لم يعد روبوت DeepSeek مجرد اسم عابر في عالم الذكاء الاصطناعي، بل أصبح محور حديث الجميع بعد أن استحوذ على صدارة متاجر التطبيقات متجاوزًا حتى ChatGPT الشهير نتيجة لذلك، حدثت اضطرابات واضحة في الأسواق المالية العالمية. في مقال سابق، قمنا بمناقشة هذا الموضوع بشكل مفصل. كل شيء عن DeepSeek والضجة التي أحدثها لا ترجع فقط لأنه يعادل أحدث النماذج الرائدة من OpenAI وMeta وGoogle بتكاليف تشغيل أقل تُخالف المتوقع، بل أيضًا لأنه نموذجًا مفتوح المصدر يمكن تحميل وتثبيت هذا البرنامج بشكل كامل على الكمبيوتر، مما يتيح استخدامه محليًا دون الحاجة للاتصال بالإنترنت. على الرغم من أن DeepSeek ليس النموذج المفتوح المصدر الأول، إلا أن إصداره R1 يُعتبر الأقوى على الإطلاق في هذه الفئة. نماذج مثل o1 وسنستعرض في الفقرات القادمة كيفية تنزيل وتشغيل DeepSeek محليًا بكل سهولة، مما يتيح لك السيطرة الكاملة على بياناتك وسرية محادثاتك.

تشغيل DeepSeek بدون إنترنت

مزايا تشغيل DeepSeek محليًا

تعتمد الروبوتات المعروفة في مجال الذكاء الاصطناعي مثل ChatGPT وCopilot وGemini وClaude على الخوادم التي تديرها الشركات التي قامت بتطويرها، حيث تُعالج بيانات المستخدمين في مراكز بيانات تقع في أماكن بعيدة، معظمها في الولايات المتحدة. يمكن حفظ هذه البيانات (المحادثات) واستخدامها لأغراض تجارية دون علمك. ولا يُعتبر خدمة DeepSeek استثناءً، حيث تشير سياسة الاستخدام والخصوصية البيانات تُخزَّن في مراكز تقع ضمن حدود الصين.

تبرز أهمية نماذج الذكاء الاصطناعي اللغوية مفتوحة المصدر، حيث توفر للمطورين إمكانية تعديلها واستنساخها بحرية، كما تسمح بتشغيل روبوتات الدردشة محليًا لتلبية احتياجات المستخدم دون الحاجة إلى الاتصال بالإنترنت. هذا يضمن حماية البيانات الحساسة من الإرسال إلى مراكز بيانات خارجية، مما يحافظ على معلوماتك الشخصية من أي تسريب أو مراقبة غير مرغوب فيها. بالإضافة إلى ذلك، يساهم تشغيل النموذج مباشرة على الجهاز في تقليل زمن الاستجابة بالمقارنة مع الخدمات السحابية، حيث يتم القضاء على التأخير الناتج عن الاتصال بالخوادم البعيدة، مما يجعل تجربة التفاعل مع الروبوت أسرع وأكثر سلاسة.

لا داعي للقلق بشأن تعطل النموذج أو توقفه لفترة مؤقتة، حيث سيظل الروبوت متاحًا على جهازك في أي وقت تحتاجه. يمكنك أيضًا تخصيصه أو تدريبه على بياناتك الخاصة، مما يوفر لك مزيدًا من المرونة في التحكم في استجابته وتحسين أدائه بما يتناسب مع متطلباتك. مع وضع هذه النقاط في اعتبارك، إليك الخطوات اللازمة لتشغيل DeepSeek R1 محليًا وبتكلفة مجانية تمامًا.

أسهل طريقة لتشغيل DeepSeek محليًا

نحتاج في الخطوة الأولى إلى تثبيت برنامج يمكنه استضافة ومعالجة بيانات نماذج الذكاء الاصطناعي بشكل محلي. يتوفر حالياً العديد من الخيارات، ولكن يبقىOllamaالمرشح الأمثل لكل المستخدمين. هذا البرنامج - مفتوح المصدر - يسهل تثبيت وتشغيل نماذج الذكاء الاصطناعي اللغوية محليًا على أجهزة الكمبيوتر، سواء كانت تعمل بنظام macOS أو لينكس أو بالطبع نظام ويندوز. لا يتطلب البرنامج من المستخدم ضبط أي إعدادات مسبقة، حيث يقوم Ollama تلقائيًا باستخدام موارد الكمبيوتر المتاحة - مثل بطاقة الرسوميات والذاكرة - ويستخدمها بكفاءة لتشغيل هذه النماذج. ومع ذلك، تظل سرعة الاستجابة والمعالجة مرتبطة بقدرات جهاز الكمبيوتر الخاص بك.

على الرغم من أن اسم البرنامج مأخوذ من نموذج "Meta Llama" المعروف، إلا أنه يوفر إمكانية التشغيل. العديد من النماذج الأخرى مفتوح المصدر، بما في ذلك DeepSeek R1 بإصدارته المتعددة. كل ما عليك فعله هو تنزيل البرنامج من موقعه الرسمي وتثبيته من خلال الضغط على زر "Install"، ثم إدخال الأمر المناسب لتحميل النموذج الذي ترغب فيه. من المهم الإشارة إلى أن برنامج Ollama لا يوفر واجهة مستخدم رسومية، بل يعتمد بالكامل على موجه الأوامر (CMD) للتفاعل مع النماذج، ولكن هناك طرق يمكن استخدامها لتجاوز هذه النقطة سنتناولها لاحقًا.

بعد إتمام تثبيت البرنامج، انتقل إلى الصفح!عبر متصفح جهازك، اضغط على القائمة المنسدلة بجانب "Tags" كما هو موضح في الصورة أعلاه. ستجد في هذه القائمة "النماذج المُقطّرة" المتاحة من نموذج التفكير المنطقي DeepSeek R1. وقدمت الشركة الصينية ستة نماذج مفتوحة المصدر بحجم أصغر بالإضافة إلى النموذج الأساسي، وتتراوح قدراتها بين 1.5 و70 مليار متغير، في حين يحتوي النموذج الأساسي على 671 مليار متغير.

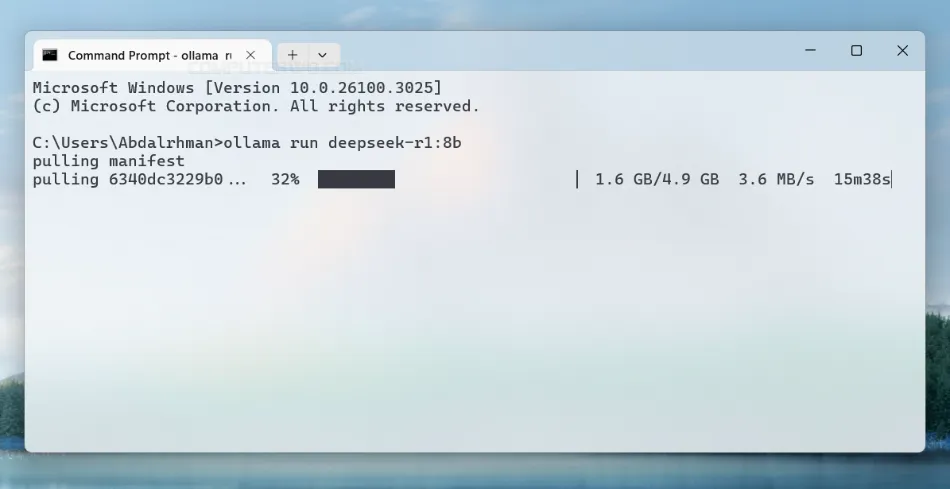

بشكل عام، الفكرة هنا هي أن النماذج الأكبر تشير إلى ذكاء اصطناعي أكثر كفاءة، لكنها تتطلب في الوقت ذاته قدرة معالجة رسومية هائلة. بمعنى آخر، كل إصدار من هذه النماذج بحاجة إلى موارد حاسوبية خاصة؛ فالنماذج الكبيرة مثل 32B و70B تحتاج إلى بطاقات رسومية قوية، بينما النموذج الأساسي "671B" يتطلب خوادم فائقة متخصصة لتشغيل النماذج اللغوية الضخمة. لذا يُستحسن البدء بتجربة النماذج الأصغر أولاً لاختبار كيفية تعامل جهازك معها. ولا داعي للقلق، فحتى الإصدارات الصغيرة من DeepSeek تقدم أداءً قويًا في مجموعة متنوعة من المهام. بعد أن تستقر على النموذج الذي ترغب في تشغيله محليًا، يمكنك اختياره من القائمة ونسخ الأمر اللازم لتحميله، مثل " ollama run deepseek-r1:8b "لتحميل نموذج Distill-Llama-8B المستند إلى R1."

بعد نسخ الأمر، افتح أداة موجه الأوامر (Command Prompt) في نظام الويندوز بأي وسيلة من الوسائل المتاحة. الطرق التي قمنا باستعراضها الطريقة الأسهل للقيام بذلك هي الضغط على مفاتيح Win + حرف S سويًا على لوحة المفاتيح لفتح شريط البحث، ثم اكتب "CMD" أو "Terminal Windows" إذا كنت تستخدم ويندوز 11، وبعد ذلك اضغط على Open من نتائج البحث. في النافذة التي ستظهر، قم بلصق الأمر واضغط على Enter. سيتولى برنامج Ollama تنزيل نموذج الذكاء الاصطناعي والملفات الضرورية لتشغيله تلقائيًا، حيث سيظهر شريط يوضح تقدم عملية التنزيل، والتي قد تحتاج إلى بعض الوقت. على سبيل المثال، عند تنزيل نموذج Distill-Llama-8B، يحتاج البرنامج إلى تحميل حوالي 5 جيجابايت من البيانات، مما يجعل سرعة اتصالك بالإنترنت عاملًا مهمًا في مدة الانتظار.

بمجرد الانتهاء من التنزيل، سيعمل نموذج DeepSeek R1 بشكل كامل على جهازك، مما يعني أنه يمكنك استخدامه دون الحاجة إلى اتصال بالإنترنت. كل ما عليك فعله هو فتح موجه الأوامر وكتابة نفس الأمر الذي استخدمته لتحميل النموذج - والذي في حالتنا هو ollama run deepseek-r1:8b – ولكن هذه المرة لن تُحمَّل أي ملفات، بل سيظهر لك مؤشر " Send a message "يمكنك كتابة سؤالك والضغط على Enter للحصول على الرد مباشرةً في نافذة الأوامر."

يمكنك أيضًا نسخ النصوص ولصقها باستخدام الفأرة، تمامًا كما تفعل عند استخدام المتصفح. لكن بما أن DeepSeek R1 يعد نموذجاً للتفكير المنطقي، قد تلاحظ أن الرد لا يظهر على الفور، بل سترى مؤشر " think/ "الذي يدل على أن النموذج يقوم بتحليل وفهم الطلب قبل أن يقدم الإجابة النهائية."

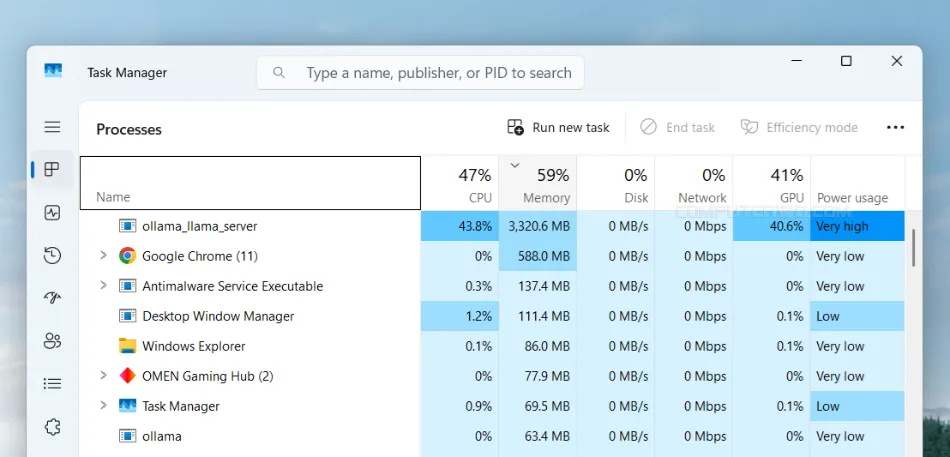

نظرًا لأن نموذج DeepSeek R1 - أو بالأحرى نسخته المصغرة - يعمل بالكامل على جهازك، قد تلاحظ استهلاكًا مرتفعًا للموارد عند تشغيله عبر موجه الأوامر، حيث يزداد هذا الاستهلاك بشكل ملحوظ أثناء توليد الإجابات. كما هو موضح في الصورة أعلاه، يستهلك نموذج Distill-Llama-8B أثناء عملية إنشاء الردود حوالي 40% من قدرة المعالج الرسومي - في حالتنا هو RTX 3050 Ti - بالإضافة إلى أكثر من 3 جيجابايت من الذاكرة العشوائية. يعكس هذا الاستهلاك كفاءة النموذج في إدارة الموارد، وهي أحد أبرز نقاط القوة لـ DeepSeek في الوقت الحالي. بشكل عام، يمكنك اختبار النماذج الأصغر أو الأكبر بحسب إمكانيات جهازك لضمان أداء سلس واستجابة سريعة.

لكن تشغيل النموذج عبر موجه الأوامر لا يُعطي تجربة مثالية، خصوصًا أن اللغة العربية غير مدعومة داخل النظام البرمجي، مما يوجب إجراء المحادثات باللغة الإنجليزية فقط. علاوة على ذلك، يُعتبر استدعاء النموذج من خلال موجه الأوامر في كل مرة أمرًا غير عملي، حيث لا يتم حفظ المحادثات كما يحدث في النسخة الخاصة بالويب. لمواجهة هذه المشكلة، يمكن الاعتماد على أدوات توفر واجهة رسومية لتسهيل استخدام النموذج محليًا. ومن بين هذه الأدوات، نوصي باستخدام برنامجChatboxنظرًا لما يوفره من مرونة وسهولة في الاستخدام، فضلًا عن دعمه لعدة أنظمة تشغيل، مثل ويندوز، وإمكانية استخدامه بلغات متنوعة، بما في ذلك اللغة العربية.

كل ما عليك فعله هو تنزيل البرنامج وتثبيته على جهازك. عند تشغيله للمرة الأولى، ستظهر لك نافذة "الإعدادات". إذا لم تظهر، يمكنك الضغط على أيقونة الترس (⚙️) الموجودة في الجهة اليسرى. بعد ذلك، اضغط على قائمة "مزود النموذج" واختر "OLLAMA API". لا تحتاج لتغيير أي إعدادات أخرى، فقط اختر اسم النموذج من قائمة "النموذج"، ثم اضغط على "حفظ".

بهذه الطريقة، يمكنك الآن استخدام نموذج DeepSeek محليًا من خلال واجهة مستخدم مألوفة. يمكنك إدخال استفساراتك أو طلباتك بأي لغة وستحصل على الإجابة – بعد انتهاء مرحلة التفكير – والتي يمكنك تعديلها أو نسخها أو طلب إعادة توليدها مرة أخرى. بالإضافة إلى ذلك، يمكنك إدراج الصور لاستخراج النصوص منها أو تضمين المستندات داخل المحادثة لطلب تلخيصها. في جميع الحالات، يعتمد النموذج على قدرات جهازك فقط، مما يتيح لك العمل دون الحاجة إلى اتصال بالإنترنت.